0

| 本文作者: AI研习社 | 2020-04-21 16:50 |

利用不确定性设计损失权重进行场景几何和语义多任务学习

理解递归神经网络中的泛化

分段线性激活实质上塑造了神经网络的损失平面

MT-BioNER:使用BERT结构的多任务学习模型进行医药领域的命名实体识别

一种面向语义表征的层次型多任务学习方法

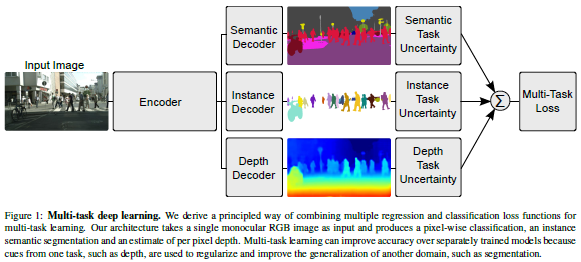

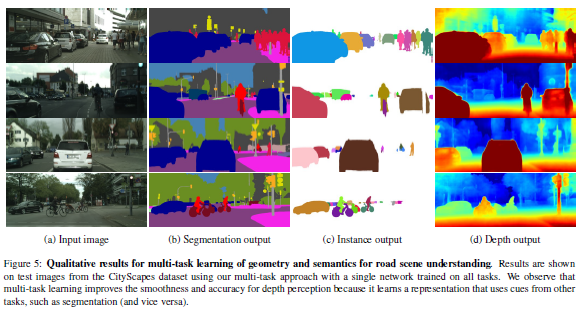

论文名称:Multi-Task Learning Using Uncertainty to Weigh Losses for Scene Geometry and Semantics

作者:Alex Kendall / Yarin Gal / Roberto Cipolla

发表时间:2018/4/24

论文链接:https://paper.yanxishe.com/review/17097?from=leiphonecolumn_paperreview0421

推荐原因

多任务学习对越来越多的任务起到了训练速度和表现分数等方面的促进作用,但是计算损失时,如何确定各个子任务的损失权重是一大难点,因为最佳的损失权重附近往往伴随着比单个模型表现更差的损失权重值。作者从任务同质不确定性(homoscedastic uncertainty)的角度,利用简化的回归、分类模型,分析了多回归任务、回归+分类任务等多任务模型的目标函数,提出了利用数据集的分布信息来设计并训练权重的方法。

按照上述方法设计的多任务模型打败了所有单任务模型并达到了SOTA,同时,作者证明了此种损失设计对于参数的初始化信息有较强的鲁棒性。

作者从贝叶斯理论的角度,提出了一种替代人工调参来确定多任务损失函数权重的方法,不仅有效,且可解释性强。这种方法未必是万能的,但是无疑是提出了一个可行的搜索子空间,为多任务学习设计损失函数提出了一种新的思路。

论文名称:Understanding Generalization in Recurrent Neural Networks

作者:Zhuozhuo Tu / Fengxiang He / Dacheng Tao

发表时间:2019/9/26

论文链接:https://paper.yanxishe.com/review/17096?from=leiphonecolumn_paperreview0421

推荐原因

此论文已被 ICLR 2020收录,来自陶大程组

在本文中,我们阐述了分析递归神经网络泛化性能的理论。我们首先基于矩阵1-范数和 Fisher-Rao 范数提出了一种新的递归神经网络的泛化边界。Fisher-Rao 范数的定义依赖于有关 RNN 梯度的结构引理。这种新的泛化边界假设输入数据的协方差矩阵是正定的,这可能限制了它在实际中的应用。为了解决这一问题,我们提出在输入数据中加入随机噪声,并证明了经随机噪声(随机噪声是输入数据的扩展)训练的一个泛化边界。与现有结果相比,我们的泛化边界对网络的规模没有明显的依赖关系。我们还发现,递归神经网络(RNN)的 Fisher-Rao 范数可以解释为梯度的度量,纳入这种梯度度量不仅可以收紧边界,而且可以在泛化和可训练性之间建立关系。在此基础上,我们从理论上分析了特征协方差对神经网络泛化的影响,并讨论了训练中的权值衰减和梯度裁剪可以如何改善神经网络泛化。

论文名称:Piecewise linear activations substantially shape the loss surfaces of neural networks

作者:Fengxiang He / Bohan Wang / Dacheng Tao

发表时间:2019/9/26

论文链接:https://paper.yanxishe.com/review/17095?from=leiphonecolumn_paperreview0421

推荐原因

此论文已被 ICLR 2020收录,来自陶大程组优必选悉尼大学人工智能中心。

理解神经网络的损失平面对于理解深度学习至关重要。本文介绍了分段线性激活函数是如何从根本上塑造神经网络损失平面的。我们首先证明了许多神经网络的损失平面具有无限的伪局部极小值,这些伪局部极小值被定义为经验风险比全局极小值更高的局部极小值。我们的结果表明,分段线性激活网络与已被人们充分研究的线性神经网络有着本质区别。实践中,这一结果适用于大多数损失函数中任何具有任意深度和任意分段线性激活函数(不包括线性函数)的神经网络。本质上,基本假设与大多数实际情况是一致的,即输出层比任何隐藏层都窄。此外,利用不可微分的边界将具有分段线性激活的神经网络的损失平面分割成多个光滑的多线性单元。所构造的伪局部极小值以底谷的形式集中在一个单元中:它们通过一条经验风险不变的连续路径相互连接。对于单隐层网络,我们进一步证明了一个单元中的所有局部最小值均构成一个等价类别;它们集中在一个底谷里;它们都是单元中的全局极小值。

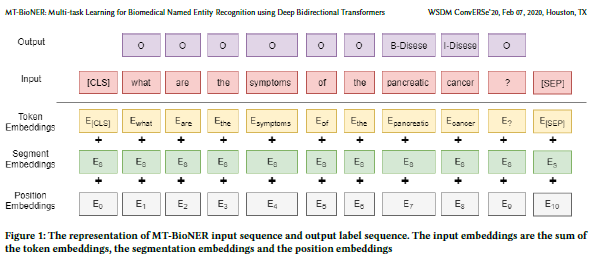

论文名称:MT-BioNER: Multi-task Learning for Biomedical Named Entity Recognition using Deep Bidirectional Transformers

作者:Muhammad Raza Khan /Morteza Ziyadi /Mohamed AbdelHady

发表时间:2020/1/24

论文链接:https://paper.yanxishe.com/review/16879?from=leiphonecolumn_paperreview0421

推荐原因

为了辅助训练聊天小助手,微软提出了一种基于BERT预训练模型的多任务模型在多个不同医学领域数据集上进行命名实体识别(NER),具体做法是以BERT预训练模型为共享层(share layer),为每个领域的数据集设置一个子任务(task specific layer),计算损失时各个子任务的权重均为1。同时,为了在不损失精度的前提下,有效地提高模型的时间和空间方面的效率,作者实验了多种训练技巧,最终选择了一起训练BERT层和共享层,并且一次随机选取一个领域数据集的mini-batch进行训练。

公平起见,作者选择了公开数据集进行实验,模型的时空效率、分数表现均达到SOTA。

这是一个很经典的多任务学习方法,用作者自己的话来说,这个模型的特点是简单高效,用softmax取代CRF,随机选取mini-batch,以及作者讨论了但是并没有加入实验的对预训练的BERT进行再次预训练的方法,都解开了不少我的疑问。同时,因为思路简单明了,作者对于实验的讲解十分详细,可学习性很强。

本文没有公开代码,但是提供了所用到的数据集。

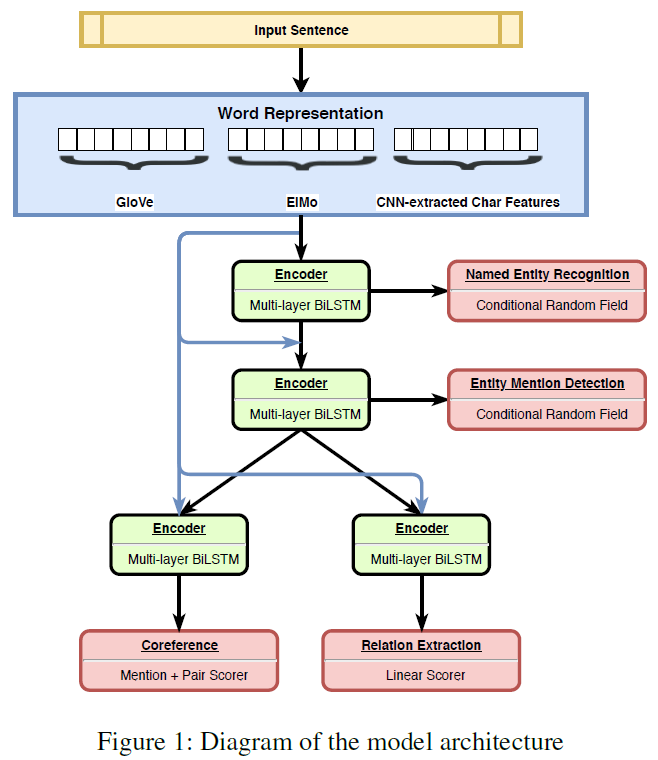

论文名称:A Hierarchical Multi-task Approach for Learning Embeddings from Semantic Tasks

作者:Victor Sanh / Thomas Wolf / Sebastian Ruder

发表时间:2018/11/26

论文链接:https://paper.yanxishe.com/review/16753?from=leiphonecolumn_paperreview0421

推荐原因

本文研究如何利用多任务学习方法(multi-task learning)来获取更为丰富的语义表征信息,具体的方法是设计一种层次结构的网络模型,用于抽取句子的上下文特征,并依据此特征,依次设计了NER(Named Entity Recognition), EMD(Entity Mention Detection), RE(Relation Extraction), CR(Coreference Resolution)等任务。其中每一个任务都有自己的BiLSTM结构进行训练,并且上层任务同时接收上下文特征、下层语义特征作为输入。训练过程中,一轮更新结束后,会随机选择一个任务以及相应的数据集进行下一轮训练。此外,作者尝试了采用不同的子任务与层次结构进行训练来观察任务组合之间的信息交互。

从效果上来看,无论是速度还是F1分数上,此多任务模型比单个任务模型(包括引入了额外语法信息的模型)均要出色。同时,作者提取各层的信息,在多个探测任务(probing tasks)上详细地分析了多任务学习方法所学到的语义表征信息。

很多研究成果都证明了,一个设计良好的多任务学习模型是很有效的,同时也是难以设计的。本文从多任务学习所学到的语义表征出发,研究如何消除灾难性遗忘(catastropic forgetting),有效从其他任务中学习语义知识等问题,效果很好。

现AI 研习社已经和阿里大文娱、旷视、搜狗搜索、小米等知名公司达成联系,为帮助大家更好地求职找工作,社区成立了AI求职内推社群,找工作找实习的小伙伴可以扫码进群了,也欢迎在读的同学来交流学习。(群里有企业hr,项目招聘人员)

雷锋网雷锋网雷锋网

相关文章:

今日 Paper | 自注意力对齐;自动化评估;关系抽取任务;LSTM模型等

雷峰网原创文章,未经授权禁止转载。详情见转载须知。